为什么要用Ollama

- 几乎是最方便的本地部署Ai大模型的方式

- 支持在 Mac、Windows、Linux 上运行

- 支持CPU,GPU

- 不用考虑复杂的本地环境

- 简直是大模型里的docker

Ollam官网的介绍是:Get up and running with large language models, locally.

安装Ollla

Mac

- 一行命令

brew install ollama

Linux

- 一行命令

curl -fsSL https://ollama.com/install.sh | sh

Windows

- 下载ollama的安装包,下载地址

- https://ollama.com/download/OllamaSetup.exe

- 安装上就即可

启动

- ollama serve 启动服务

- ollama list 查看本地的模型

- ollama run 启动模型

配置Ollama

设置服务

- vim /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

ExecStart=/usr/local/bin/ollama serve

#User=ollama

#Group=ollama

User=root

Group=root

Restart=always

RestartSec=3

Environment="PATH=/root/anaconda3/bin:....{这里是你的环境变量}"

[Install]

WantedBy=default.target

- 保存后执行

sudo systemctl daemon-reload

sudo systemctl enable ollama

systemctl start ollama

- 可以通过以下命令来查看日志

journalctl -u ollama - 查看状态

systemctl status ollama

下载模型

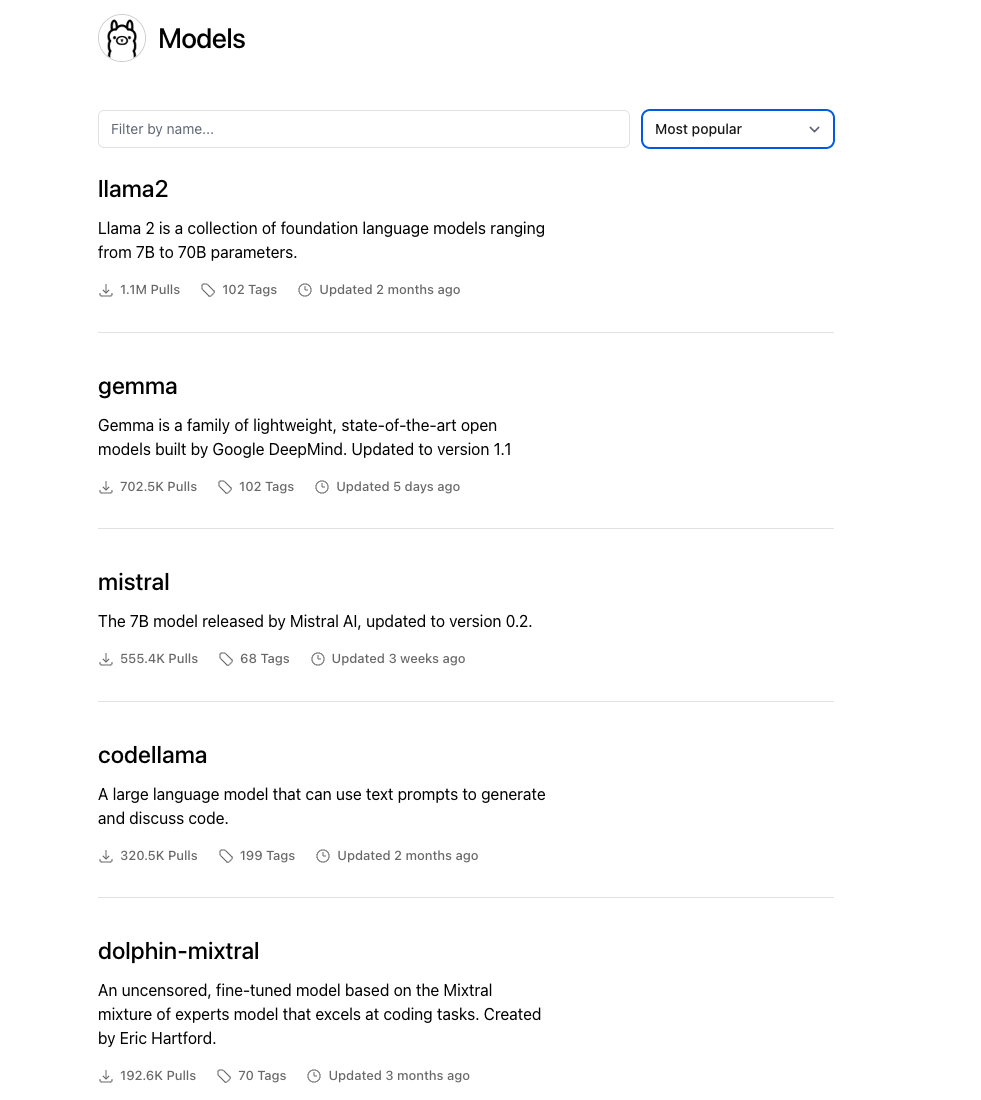

- 配置Ollama需要先安装模型,目前支持的模型有:

- 可以在这个页面查找所有模型:https://ollama.ai/library

运行模型

方式1: 命令行

ollama run llama2-chinese #meta开源的模型

ollama run gemma:2b #google 开源模型;

ollama run qwen #阿里开源模型

- 此时会出现一个窗口,输入内容,然后就可以看到模型生成的内容了

- 下载的模型会保存在 ~/.ollama/models/

- 模型会自动下载,下载完成后,就可以直接使用

方式2: 接口

- 访问http://localhost:11434/api/v1/models

- 输入模型名称,例如llama2-chinese

curl http://localhost:11434/api/chat -d '{

"model": "mistral",

"messages": [

{ "role": "user", "content": "天空为什么是蓝色?" }

]

}'

- 访问http://localhost:11434/api/v1/generate

- 输入模型名称,例如llama2-chinese

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt":"天空为什么是蓝色?"

}'